ChatGPT 在全球市场的成功,引爆了全球主要科技公司在 AI 领域进行军备竞赛,作为“云计算第一股”的优刻得(688158.SH)正深切地感受到这种市场变化。

“前端的订单确实非常多。”近日,优刻得新兴产业事业部总经理韩畅在接受 21 世纪经济报道记者专访时表示,“AIGC 的概念是从去年 10 月开始升温,于今年年初开始火爆。AI 对算力的需求发生了翻天覆地的变化,一是算力规模的扩大,二是高性能算力需求的增长,三是对数据中心的需求呈现出一些具体的变化。”

在市场人士看来,云计算的核心是通过云端提供海量算力,从这个角度来说,拥有云基础设施就有了跑通 AI 算力、AI 大模型和生成式 AI 应用的入场券,云计算厂商也就成为了大模型入口处的“铺路人”。

据 IDC 预测,到 2025 年,支撑云计算的硬件、软件和云服务,以及云相关的专业和管理服务市场空间到 2025 年将超过万亿元人民币,云计算在中国具有巨大的潜在空间。

面对这个火热的市场,云计算厂商在感到兴奋的同时,也在思考一系列的问题:如何找通过替代方案来降低 GPU 等设备成本,当下数据中心配置能否满足海量的数据运算需求?

一、算力需求极速增长

韩畅负责的新兴产业事业部在优刻得属于前端业务部门,今年接触了很多前沿的 AI 产业。从客户反馈来看,她直观地感受到 AI 带给云计算行业的变化。

“首先是算力规模呈现出非常大的提升。比如,以前个别客户有一些小型的训练或推理需求会租用我们的设备,按卡的数量来说,大致是一两百张的规模。但大模型兴起之后,参数量达到百亿或千亿的模型,需要的 GPU 训练卡的数量就是数百张甚至数千张的规模,对 GPU 卡需求量在大大地增加。”韩畅说。

其次,客户对 GPU 卡的性能也有了明显不一样的需求。“以前比如用英伟达 T4 或者 V100 就可以满足客户需求。但大模型兴起后,客户就想用 A800 以及未来的 H800 来做模型训练。这两种 GPU 显卡相比于以前的版本,运算性能大幅提升。”她对记者表示。

记者整理公开数据发现,英伟达 V100 芯片 NVLink 互联速率为 300GB/S,拥有 7TFlops FP64 双精度、14TFlops FP32 单精度计算能力;GPU 显存为 32/16 GB HM2e,显存带宽为 900GB/s。而 A800 芯片 NVLink 互联速率达到 400GB/S,拥有 9.7TFlops FP64 双精度、19.5TFlops FP32 单精度计算能力;GPU 显存为 80GB HBM2e,显存带宽达到了 1935GB/s。

而作为搭载 GPU 等设备的物理载体,数据中心的运行也在发生细微变化。

韩畅介绍,“大模型兴起之后,对于单机架的电力要求也变得非常大。”她向记者举了一个例子,“以一台 A800 的 GPU 服务器为例,需要 30 安的机柜,如果升级到 H800,就需要 50 安的机柜。同时用户又要进行集群训练,那就需要在数据中心部署很多台 CPU 设备,单台机柜的电力也相应提高,云计算服务商的资金投入也会相应提高。”

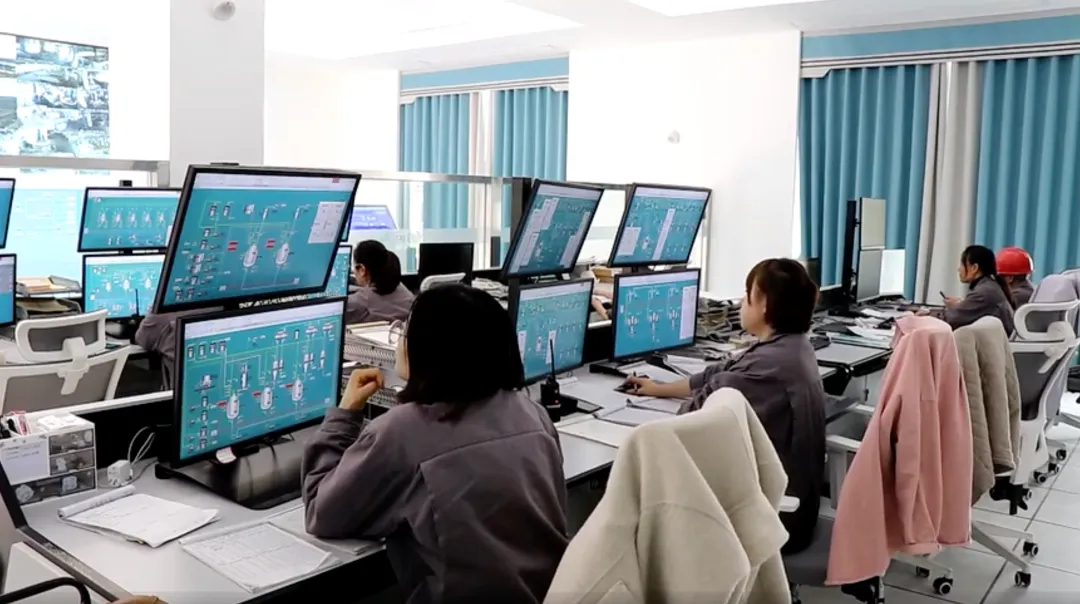

作为算力基础设施的重要组成部分,数据中心正成为人工智能产业化进一步发展的关键。据了解,优刻得已在国家“东数西算”枢纽自建的乌兰察布数据中心部署了多款 GPU 高性能计算产品,上线了英伟达的 V100S、A800 等多款显卡;此外,该数据中心还部署了新一代归档存储产品 US3、提供海量训练数据存储服务。

总的来说,为满足市场上对算力的需求,优刻得通过自建的数据中心和多年云计算运营经验,更能进行机柜、网络、服务器等算力相关设施的定制。据了解,优刻得除了对 GPU 这种算力资源芯片进行了升级,对网络也进行了升级,让 IB 网络具有更大的互联带宽,实现更低延时、更高吞吐以及更智能的网络连接,从而大大提升大模型的训练效率。在存储方面,公司实现对数据生命周期管理、将冷热数据分层,从而降低 80%的存储成本。算法方面,则是对硬件性能优化来进行加速。

二、制约算力的关键环节

回到产业链条上,算力是制约国内大模型发展的重要因素。

“虽然这不是唯一的制约因素,但确实非常重要,如果算力不足的话,很难在相对可控的时间内来满足训练和部署大模型的需求。”韩畅说。

进一步梳理 AI 算力产业链,其涉及的基础设施包括 AI 芯片及服务器、交换机及光模块、IDC 机房及上游产业链等。从上述变化来看,GPU 等关键硬件设备又是制约算力发展的关键环节。

韩畅坦言,算力的底层基础设施特别重要,就目前的情况来看,国内的产业链仍很大程度上依赖英伟达的显卡去做大模型训练。此外,在算法优化、数据流通上也面临着挑战。

据记者了解,英伟达显卡在市面上几乎“一卡难求”,一位业内人士曾对记者表示,用来作大模型训练的芯片需求强劲,价格翻了数倍。

“现在国内 GPU 厂商也在不断壮大,大模型的兴起对他们而言是一个非常大的利好。但就应用而言,二者还是有一些差距。”她说,“(差距)更多的体现在性能上,要知道,硬件性能的优化是需要软件的兼容性去适配的,整个生态体系的建设需要时间。国内的 GPU 厂商正在努力追赶英伟达的脚步,需要更多的产业链环节一起参与进来。”

韩畅认为,首先需要大模型公司的参与;其次,云厂商作为一个基础设施提供商也要参与进来;另外,一些应用大模型的细分赛道的客户也应投身其中。“在产业链的共同努力下,相信未来国内算力芯片也能达到 AI 大模型发展需求。”

实际上,从大模型训练的基础——数据来看,也面临着流通的问题。“国内还需要高质量、稀缺性、合规的数据流通渠道,目前来说,我们在与大模型公司的沟通中,他们对一些行业数据的需求其实是非常迫切的,而大量高质量数据的缺乏,也一定程度上限制了大模型的发展。”韩畅指出。

就当前优刻得的客户分类而言,也能看出国内大模型的发展阶段。“大模型先要进行不断地训练,之后再转入推理,也就是用大模型为不同行业提供服务。目前我们的客户还是以训练阶段为主。”韩畅说。

她向记者举了一个例子:“某个客户训练卡和推理卡数量的配比大致是 5:1,也就是仍属于前期阶段,随着之后商业化推进,训练和推理的配比会从 5:1 降到 3:1 降到 1:1、1:5,甚至更多,大量的训练会转到推理上,对算力又会涌现巨大的需求。”